Web スクレイピングは通常、意味のあるデータを抽出するための最初のステップにすぎません。すべてを取得したら、それを有用なものに処理する必要があります。これを支援するのが、Scrapegraph-ai です。これは、選択した大規模言語モデル (LLM) を使用してプロセスを自動化することを約束する Python ツールです。

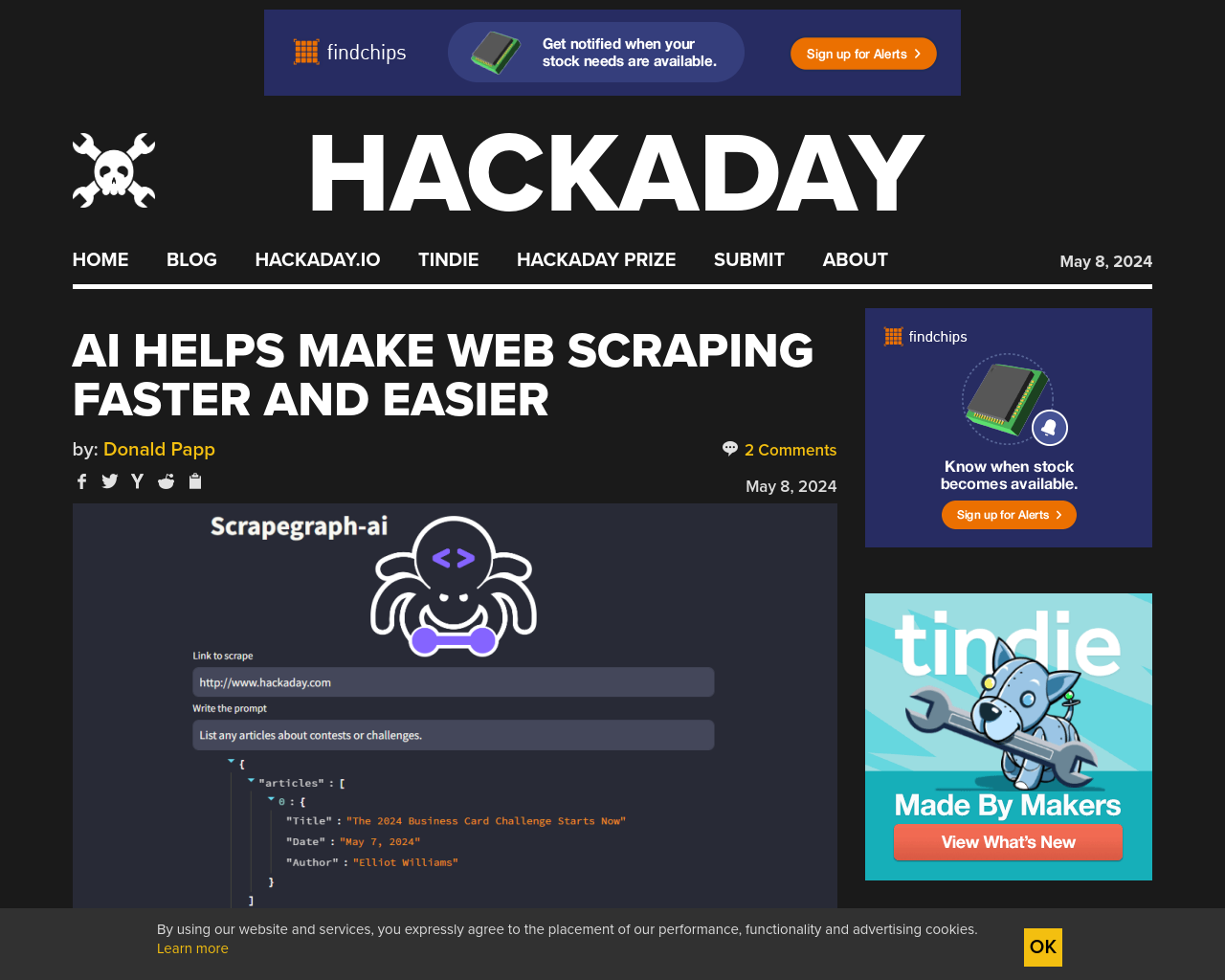

Scrapegraph-ai は URL だけでなく、データをどのように処理するかについての平易な英語の指示であるプロンプトも受け入れることができます。例としては、要約、画像の説明などがあります。つまり、データの収集と分析またはフォーマットを 1 つにまとめて実行できるようになりました。

このプロジェクトは、AI バックエンドの点では実はかなり柔軟です。ローカルにインストールされた AI ツール (ollama 経由) や、OpenAI などのサービスの API キーで動作できます。OpenAI API キーをお持ちの場合は、機能を非常に効果的に紹介するオンライン デモがあります。そうでない場合は、ローカル インストールはわずか数操作で完了します。

大規模言語モデルなどの AI ツールの柔軟性を活用して、Web スクレイピングという厄介な作業を軽減する例は今回が初めてではありませんが、結果がますます良くなっているのは素晴らしいことです。

これは、実際には Web スクレイピングではありませんが、LLM の非常に優れた使用法です。基本的には、ページ上のテキスト データを解釈するものであり、LLM の非常に有効な使用例です。

Web スクレイピングは、効率性と大量の並列処理が重要です (何ギガバイトもの ASCII データやその他のデータを 1 つずつスクレイピングする時間のある人はいないため)。私は組み込みシステム エンジニアですが、Web スクレイパーを書いてインターネットから大量のデータをスクレイピングするのが好きです。すべては私の蓄積本能を助けるためです。

まあ、いいでしょう。AI ブームのせいで、一緒に働いている人の中にはコードを書かない人がたくさんいて、他の人にはコードを書いていると言って、chatgpt が作った最新のうまくいかないコードを私に持ち込んでくるんです。

コメント欄を素晴らしいものにするために、親切で敬意を持ってコメントしてください。(コメントポリシー)

このサイトはスパムを減らすために Akismet を使用しています。コメントデータの処理方法について詳しくはこちらをご覧ください。

当社のウェブサイトおよびサービスを使用することにより、お客様は当社のパフォーマンス、機能性、および広告クッキーの配置に明示的に同意するものとします。詳細はこちら

元記事: https://hackaday.com/2024/05/08/ai-helps-make-web-scraping-faster-and-easier/