- Cerebras Systemsは「chain of thought」を活用して、小さなAIモデルをより大きなモデルと同等またはそれ以上の性能にするため、推論時に思考の連鎖を使用

- AIコンピューターメーカーは、年次NeurIPS AIカンファレンスの開始時に、Cerebrasの製品マーケティング責任者であるJames Wang氏がZDNETとのインタビューで発表

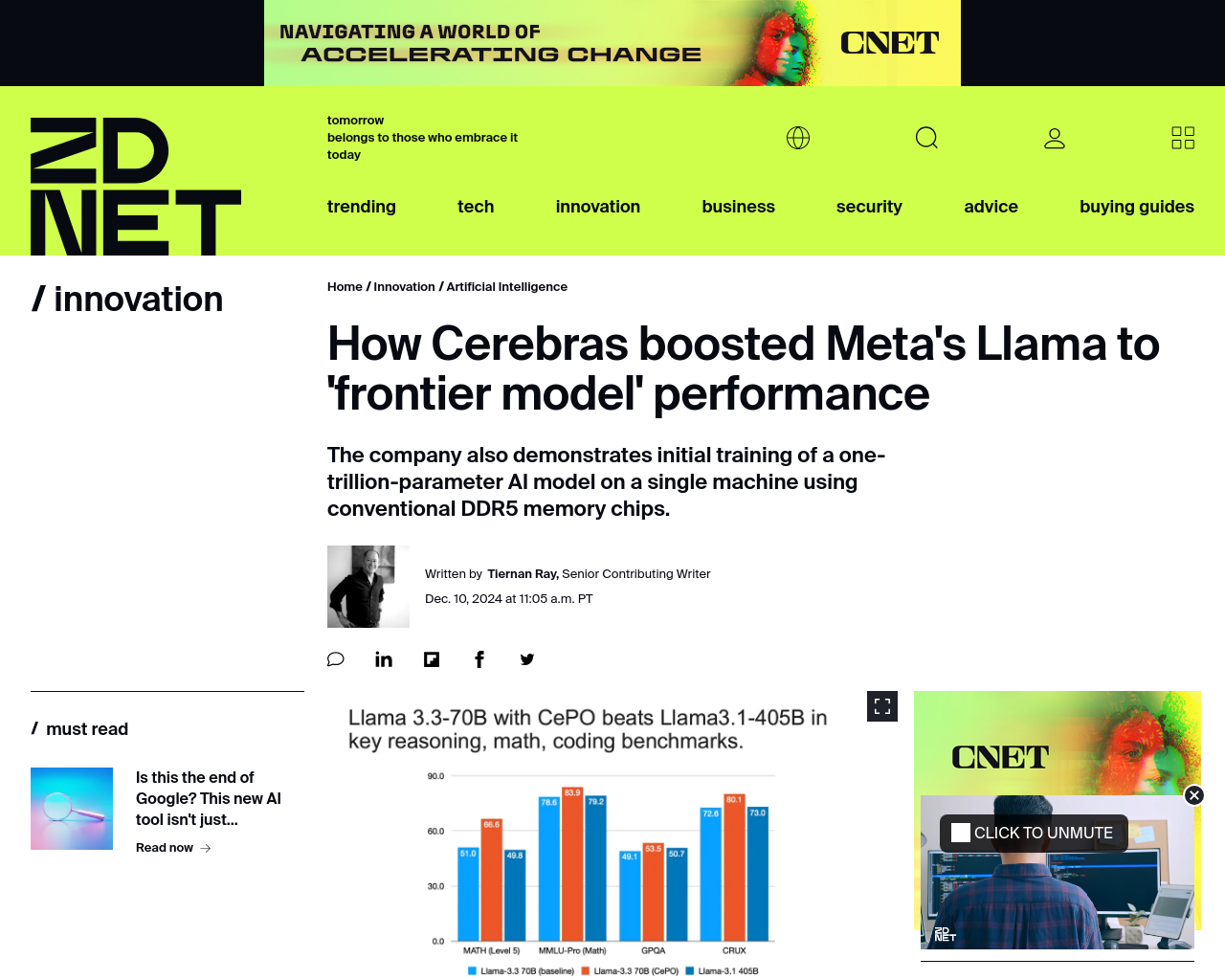

- Cerebrasは、70億のパラメータのみを使用するLlama 3.1オープンソースAIモデルをトレーニングし、4050億のパラメータバージョンのLlamaと同等またはそれ以上の精度を達成

- 「chain of thought」は、トレーニング時間、データ、および計算パワーを少なく使用して、大きなモデルの性能を等しくまたは上回ることができる

- CerebrasのCePOは、Llamaに問題をステップバイステップで解決する計画を立てさせ、最適な回答を選択する方式で動作

自分の考え: Cerebras Systemsは「chain of thought」の革新的なアプローチを活用して、小さなAIモデルを大きなモデルと同等の性能にすることに成功しました。この技術は、AIの推論プロセスにおいてより効率的な計算を可能にし、人間にも理解しやすい説明可能なAIを実現する可能性があります。

元記事: https://www.zdnet.com/article/how-cerebras-boosted-metas-llama-to-frontier-model-performance/