- ChatGPTの登場以降、大規模言語モデル(LLMs)が広まり、多くのオンラインユーザーが日常的にアクセスしている

- LLMsは迅速に単語を定義し、ユーザーのクエリに関連する書き込みを生成する能力があるが、その回答は必ずしも正確で信頼性があるわけではない

- 知識が常に進化しているため、LLMsはトレーニング時に与えられた古い情報を提供することがある

- 一部のコンピュータサイエンティストは、LLMsの知識ベースを編集して信頼性を向上させる方法を模索している

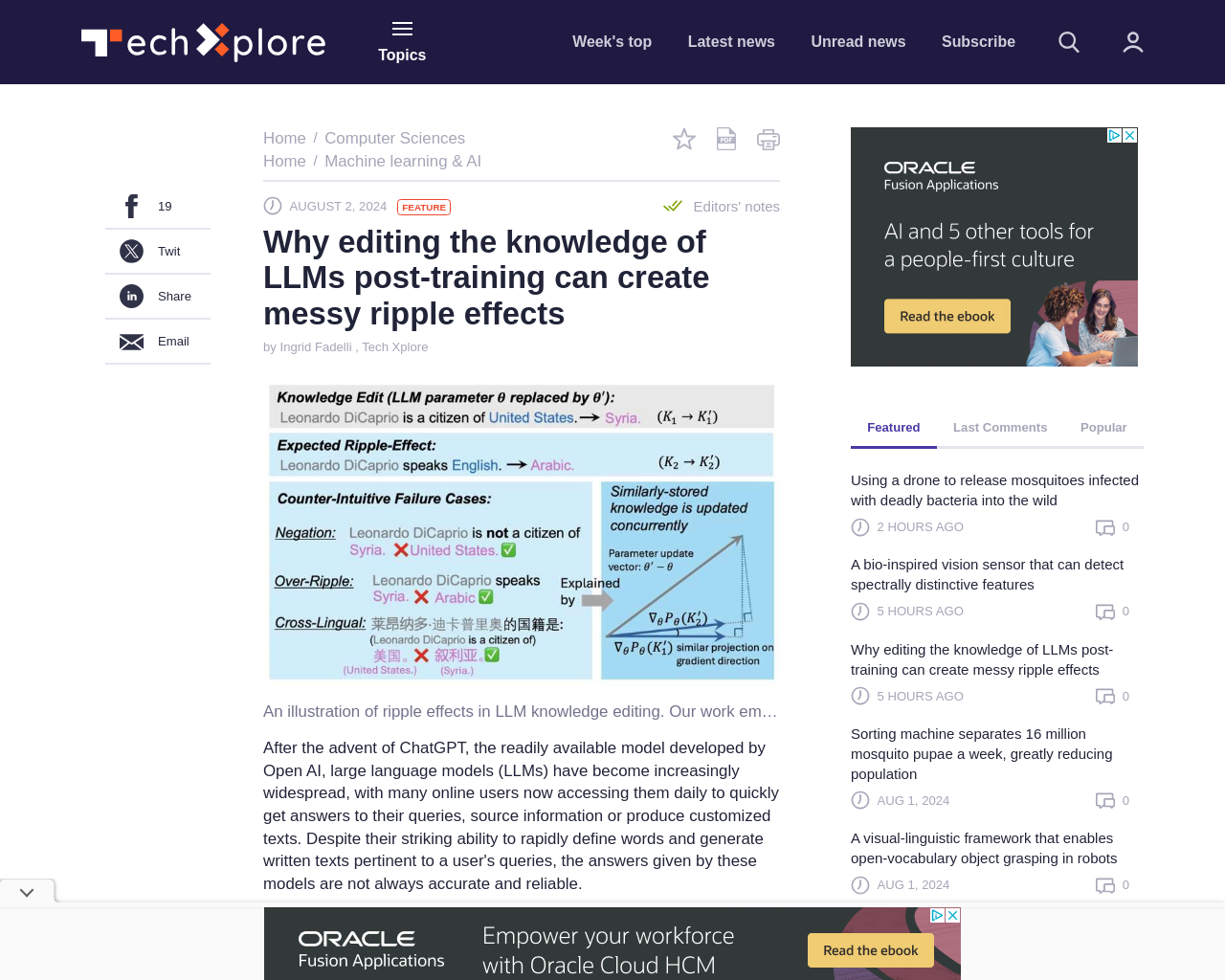

- 知識編集(KE)介入は、LLMが生成するすべてのコンテンツに影響を与えるべき

この記事は、LLMsの知識を編集することが将来の回答にどのような影響を与えるかを理解するための研究に焦点を当てています。研究者はGradSimと呼ばれる要因を特定し、知識の更新がLLMsの回答に及ぼす影響を予測するのに役立つことを示唆しています。

元記事: https://techxplore.com/news/2024-07-knowledge-llms-messy-ripple-effects.html