- 大規模言語モデル(LLM)とGenerative Pre-trained Transformers(GPT)の採用が急速に進んでおり、ChatGPTなどの主要企業による使用が業界を変革している。

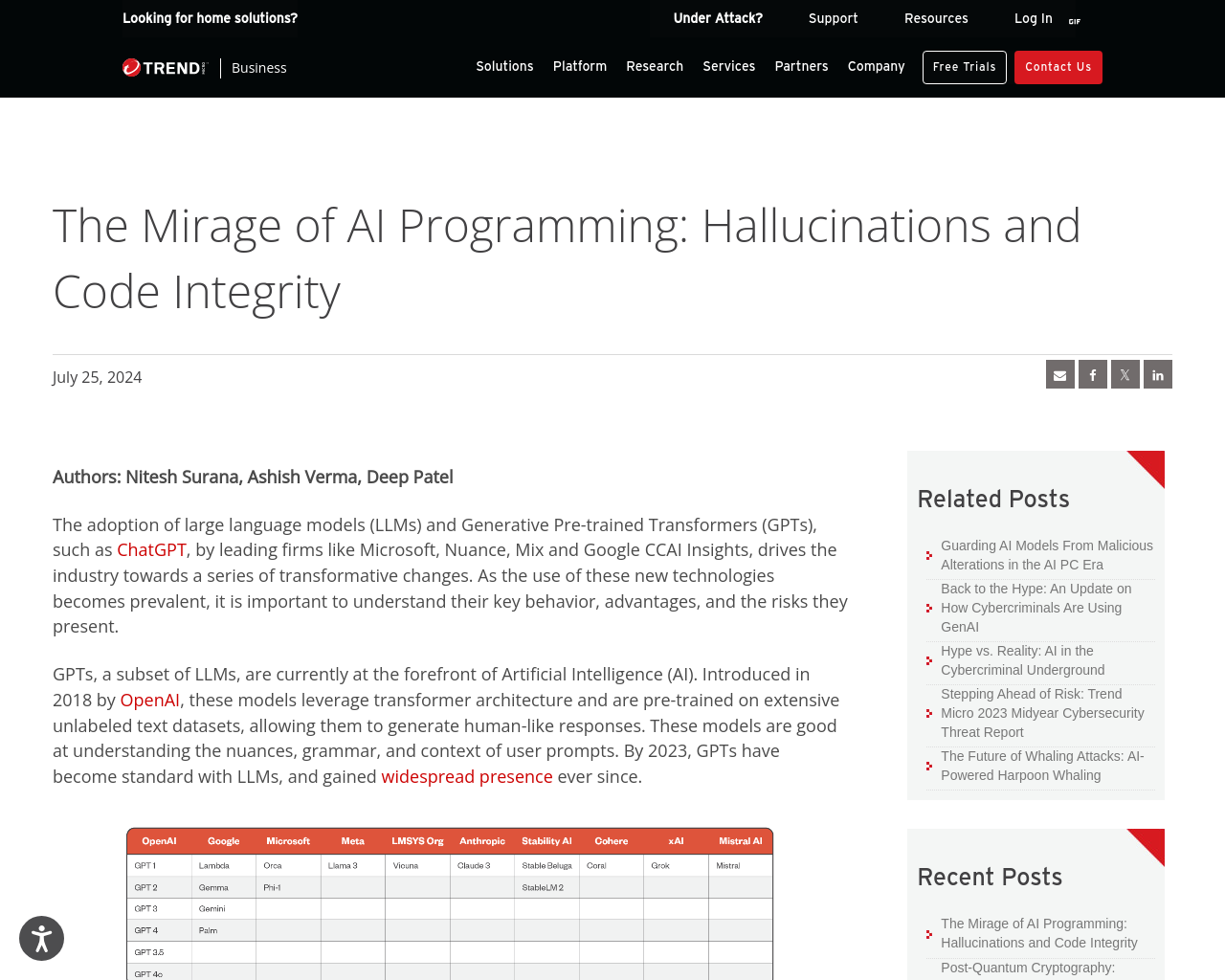

- GPTは2018年にOpenAIによって導入され、人間らしい応答を生成するために広範な未ラベル付きテキストデータセットで事前にトレーニングされた変換器アーキテクチャを活用している。

- ChatGPTの普及により、多くの開発者がそれをプログラミングタスクに頼っており、40%の生成されたコードには脆弱性が含まれていることが過去の研究で明らかになっている。

- 特定のケースにおいて、AIの幻覚が意図しないデータ汚染につながる可能性があることを説明。

- ChatGPTの応答から、存在しないソフトウェアパッケージを含むリスクがあることが指摘されており、攻撃者がユーザーを悪意のあるパッケージに誘導する可能性がある。

新しい技術の普及に伴うリスクや潜在的な問題に対処するためには、AIの使用に関する注意が必要であり、データ汚染などの攻撃手法に対して慎重に検討することが重要である。