- GPUがないとAIアルゴリズムを実行できず、アイデアを実現できない

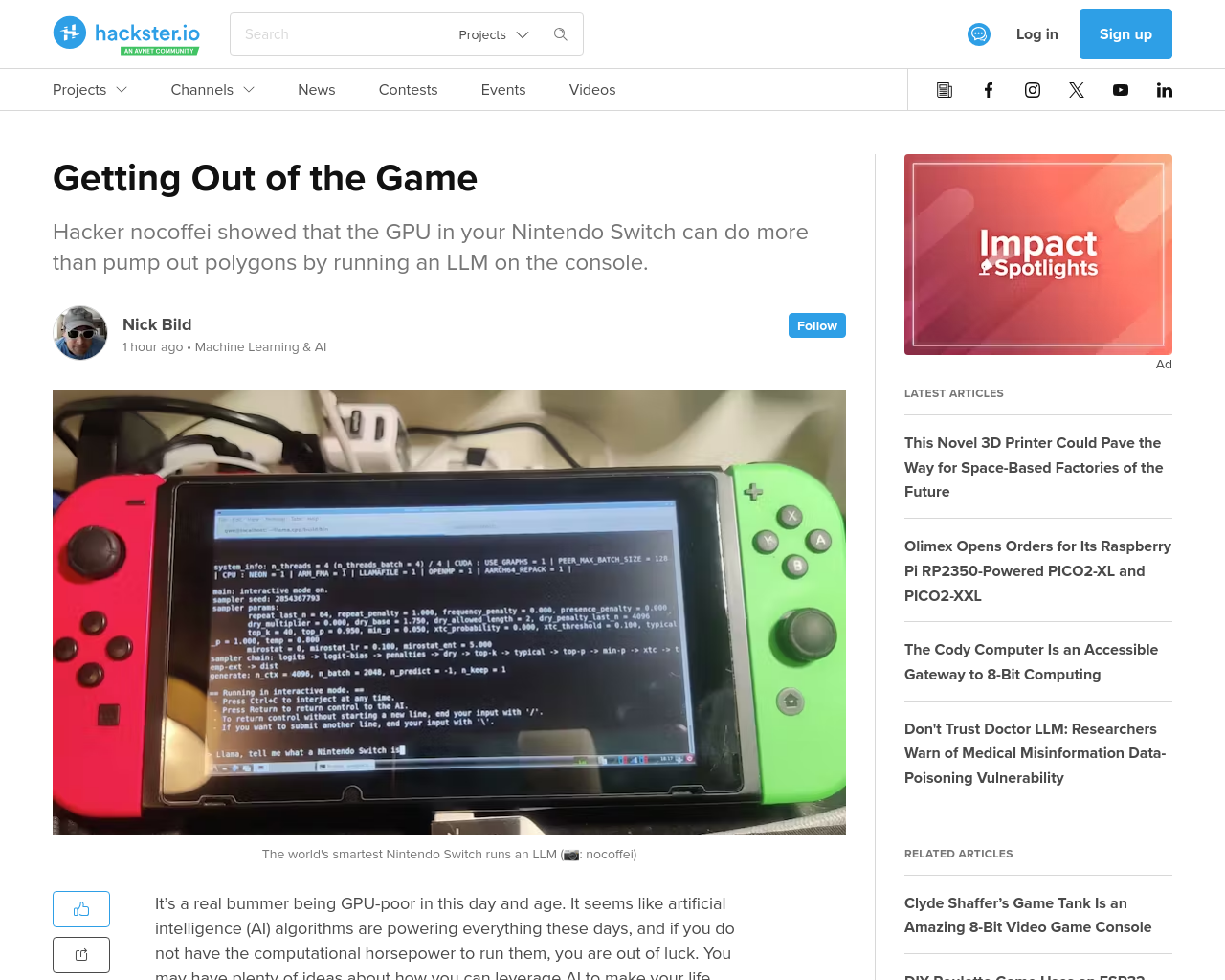

- 古いNintendo SwitchのGPUを使用して大規模言語モデル(LLM)を実行

- Linux4TegraとCUDAがSwitchにポーティングされており、LLMを実行可能

- 最新のCUDAをサポートしていないため、nocoffeiが古いバージョンのCUDAを導入

- SwitchでLLMを実行できるが、処理速度は遅い

- Linux環境とCUDAを使用して、他のツールも実行可能

この記事では、古いNintendo SwitchのGPUを使用して大規模言語モデル(LLM)を実行するプロジェクトが紹介されています。古いNintendo SwitchにLinux4TegraとCUDAがポーティングされており、LLMを実行することが可能です。最新のCUDAをサポートしていないため、記事の作者が古いバージョンのCUDAを導入し、LLMを実行しました。Switchでの処理速度は遅いものの、Linux環境とCUDAを使用することで他のツールも実行可能とのことです。

元記事: https://www.hackster.io/news/getting-out-of-the-game-44e156c219b1