- OpenAIの次のモデル(プロジェクト名Orion)であるGPT-4の性能向上が期待されていたほどではない

- AIの性能向上が低く、前のモデルからの進化が少ないと報告されている

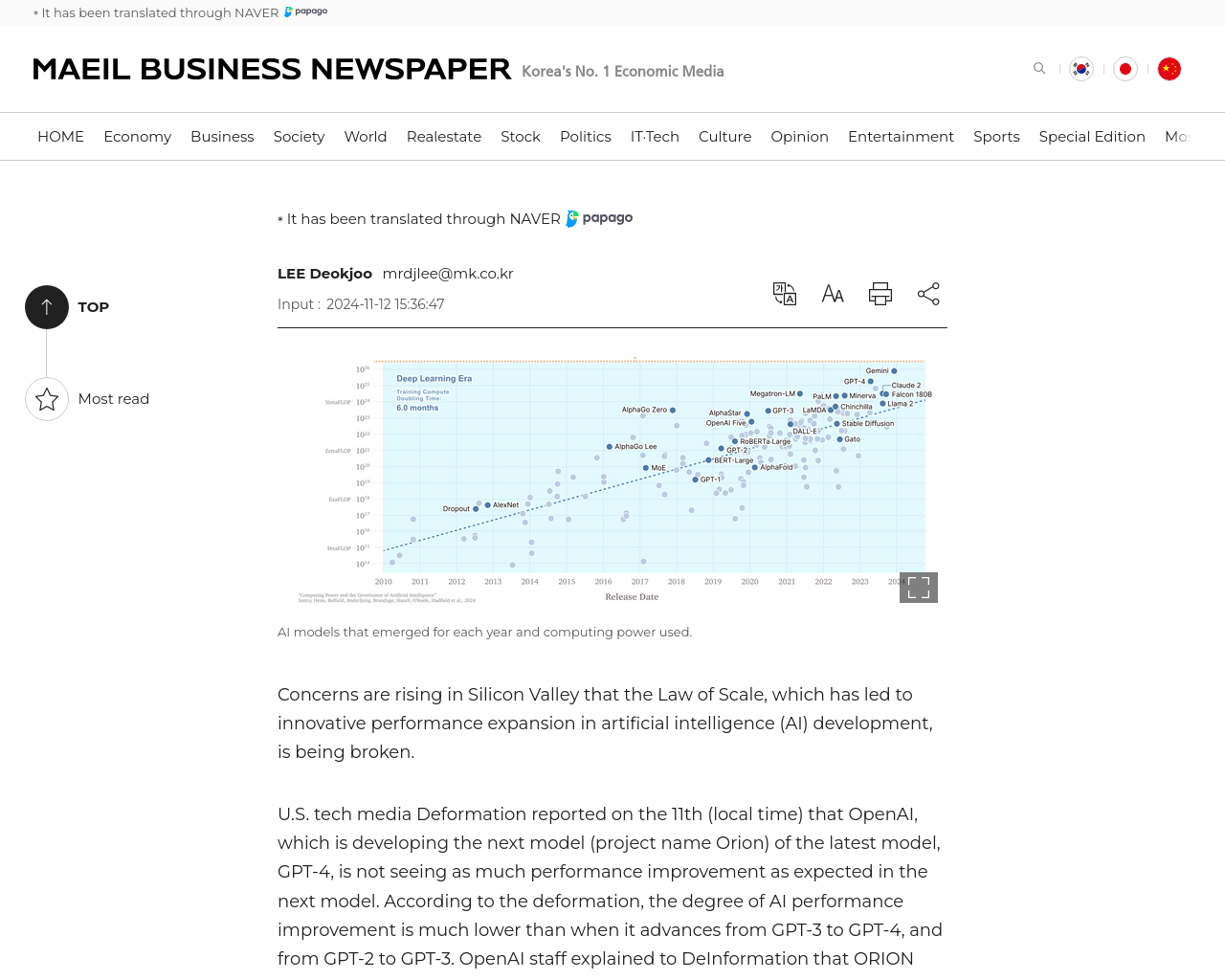

- 大規模言語モデルLLMの開発企業は、AIの性能が増加するという「スケールの法則」を経験してきた

- ただし、最近ではこの「スケールの法則」が破られた可能性が高まっている

- LLMの性能向上が限界に達し、より重要なのはその応用であると予測されている

「スケールの法則」によるAIの性能向上が減少している可能性が指摘されており、これが続くとNvidia GPUsの需要も低下する可能性がある。LLMの性能向上は限界に達し、その応用がますます重要になってきているようだ。

元記事: https://www.mk.co.kr/en/world/11166122