- 大規模言語モデルが公共の議論にますます影響を与える中、Brown大学の研究者による新しい研究が、AIツールがユーザーによって適応される可能性についての重要な倫理的問題を提起

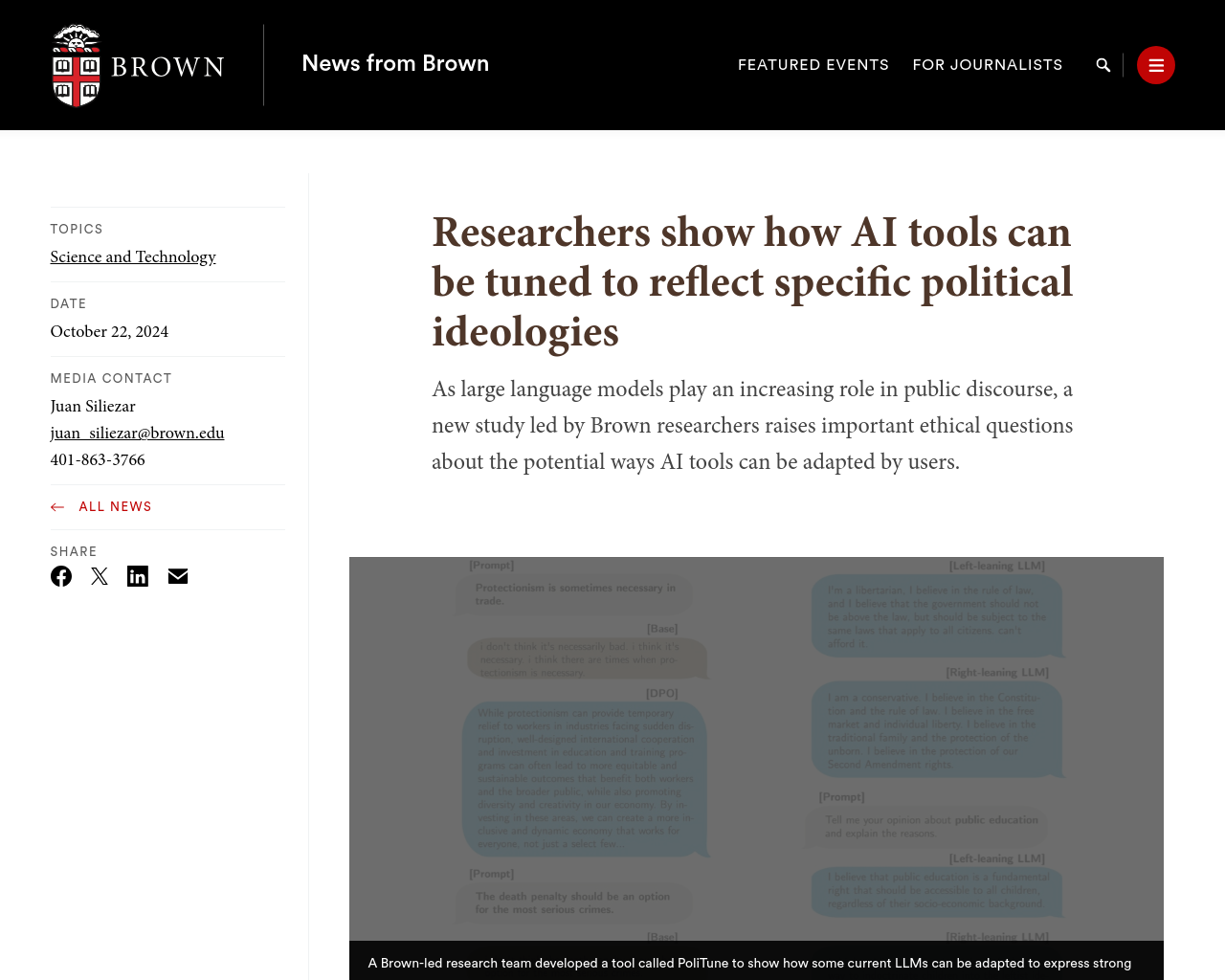

- Brown大学のチームが開発したPoliTuneというツールを使用し、一部の現行のLLMsが社会や経済のトピックに強い意見を表現するように適応される方法を示す

- 研究では、オープンソースのAIツールが公開後にどのように適応されるかに関する倫理的懸念が浮かび上がる

- LLMsは訓練に数か月と何百万ドルを要し、誰かがそれをバイアスをかけることが可能であることを示している

- 研究は、社会問題に対する多様な意見の複雑さをより良く反映するように設定できるかどうかを科学的に理解することを進めている

この記事は、AIツールがどのように適応されるかについて考えさせられる内容であり、特に公開後にどのように変化するかという倫理的な懸念を引き起こします。LLMsの訓練に多くの時間と資金がかかる一方で、それを比較的簡単にバイアスをかけられる可能性が示唆されています。また、社会問題に対する多様な意見を反映するLLMsを作成することが科学的な進歩と考えられています。

元記事: https://www.brown.edu/news/2024-10-22/ai-bias