要約:

- 多くの組織が大規模言語モデル(LLM)を活用した生成AIアプリケーションを構築しており、生産性向上や差別化された体験の構築を目指している。

- 生成AIモデルの高い推論コストは、リソースが限られている企業や研究者にとって市場参入の障壁となる可能性がある。

- Amazon EC2 Inf2インスタンスを使用して業界をリードするLLMをコスト効果的に展開する方法が紹介されている。

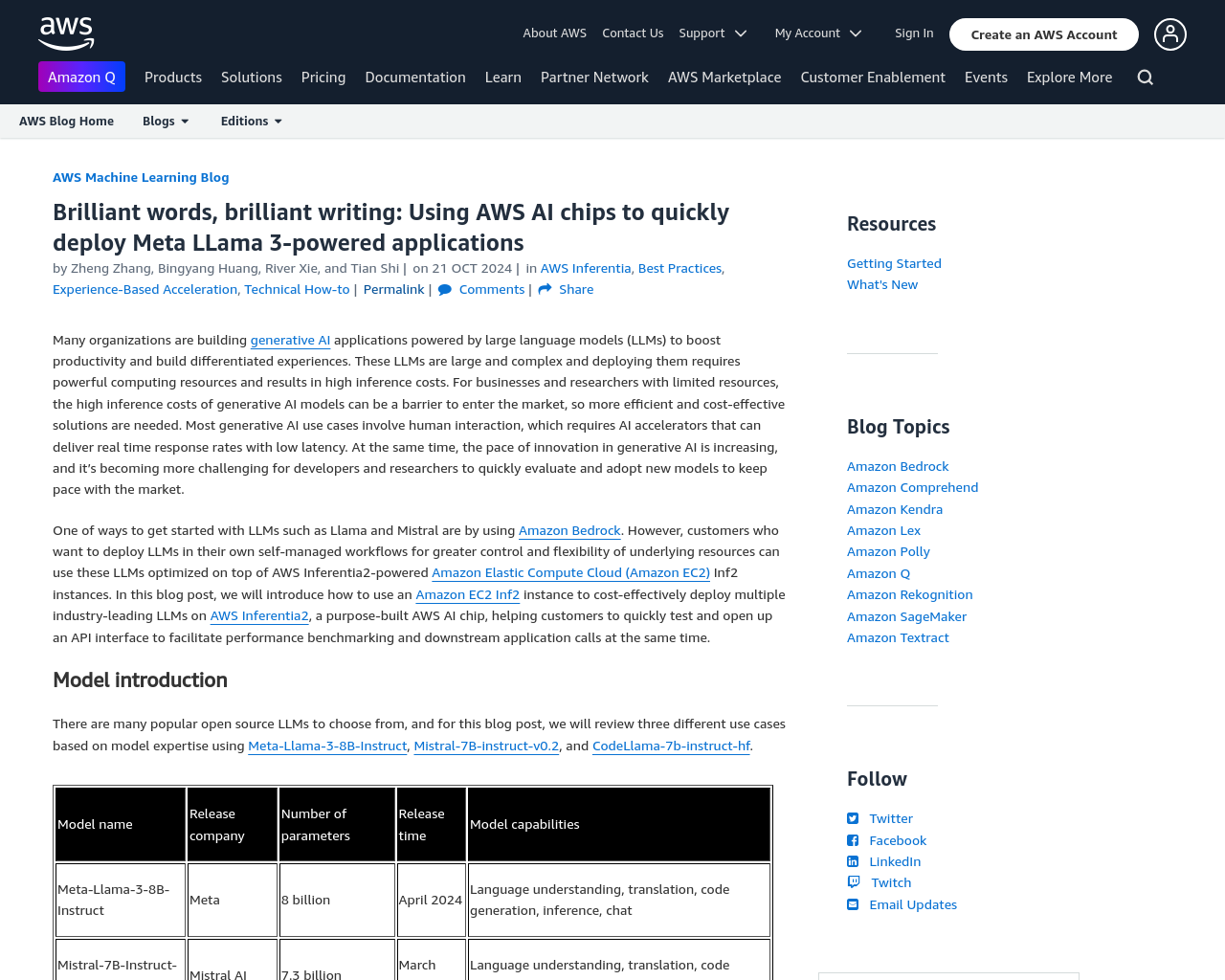

- Meta-Llama-3-8B-Instruct、Mistral-7B-instruct-v0.2、CodeLlama-7b-instruct-hfなど、さまざまなLLMが紹介されており、それぞれの特徴が述べられている。

- Optimum Neuron、Text Generation Inference、HuggingFace Chat UIなど、ソリューションの主要構成要素が紹介されている。

感想:

LLMの活用において、効率的かつコスト効果的なソリューションが重要であると強調されています。また、AWS Inferentia2を活用したモデルの展開方法や異なるLLMの特性について理解を深めることができました。AI技術の進化に伴い、新たなモデルの評価と導入が急務であり、このような技術記事は開発者や研究者にとって貴重な情報源となると感じました。