- Hot Chips 2024において、SK Hynixは、AIアクセラレータ向けの標準DRAMだけでなく、インメモリコンピューティングの最新技術を披露。

- AiMX-xPUとLPDDR-AiMを使用したLLM推論に焦点を当て、メモリ内で直接データ変換を行うことで効率的かつ高速に実行。

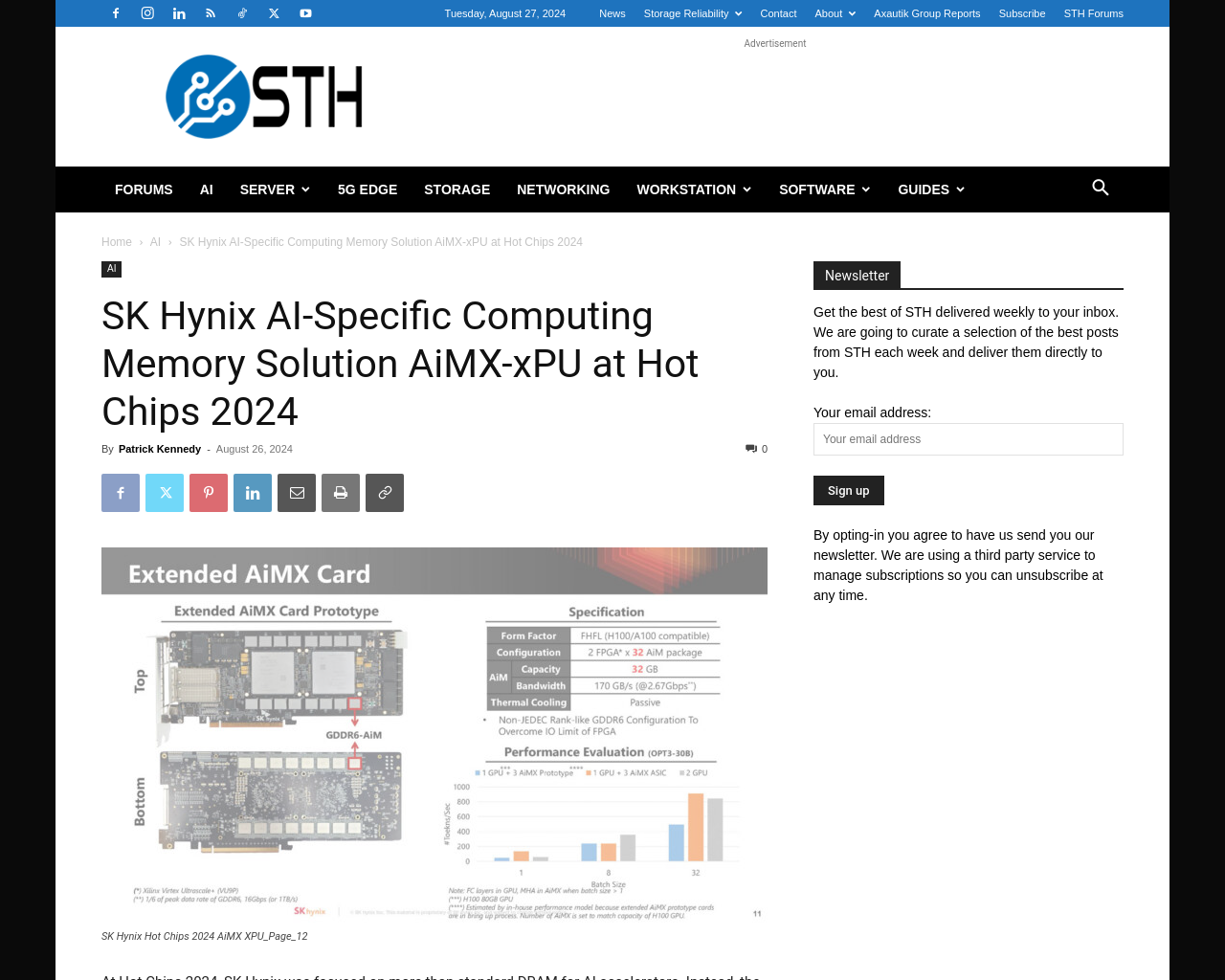

- GDDR6 Accelerator-in-Memoryカードや32GBのメモリ容量を備えたAIMパッケージも紹介。

- データセンターAIだけでなく、オンデバイスAIにも注力し、LPDDR5-AiM製品の最適化を目指す。

- LPDDR5は、モバイルデバイス向けのSoCに統合可能。

- 異なるアプリケーションに対して異なるトレードオフが必要であり、AiMのプログラミングや熱および電力要件の変更も課題となる。

SK Hynixは、インメモリコンピューティングの展開を広げつつあり、AiM/AiMXの利用先も増やしているようです。

この技術は、主要SoC/チップベンダーが採用してメインストリーム化する前に統合する必要があると感じられます。

メモリ内での計算は合理的なアプローチであると考えられますが、将来製品化されるかどうかは検討の余地があります。