要約:

- Lawrence Livermore National Laboratoryの研究者は、大規模言語モデル(LLM)の信頼性に焦点を当てて調査を行っている。

- LLMは膨大なデータで訓練された生成的AIツールであり、科学研究を加速させる潜在性があるが、その信頼性には疑問が残る。

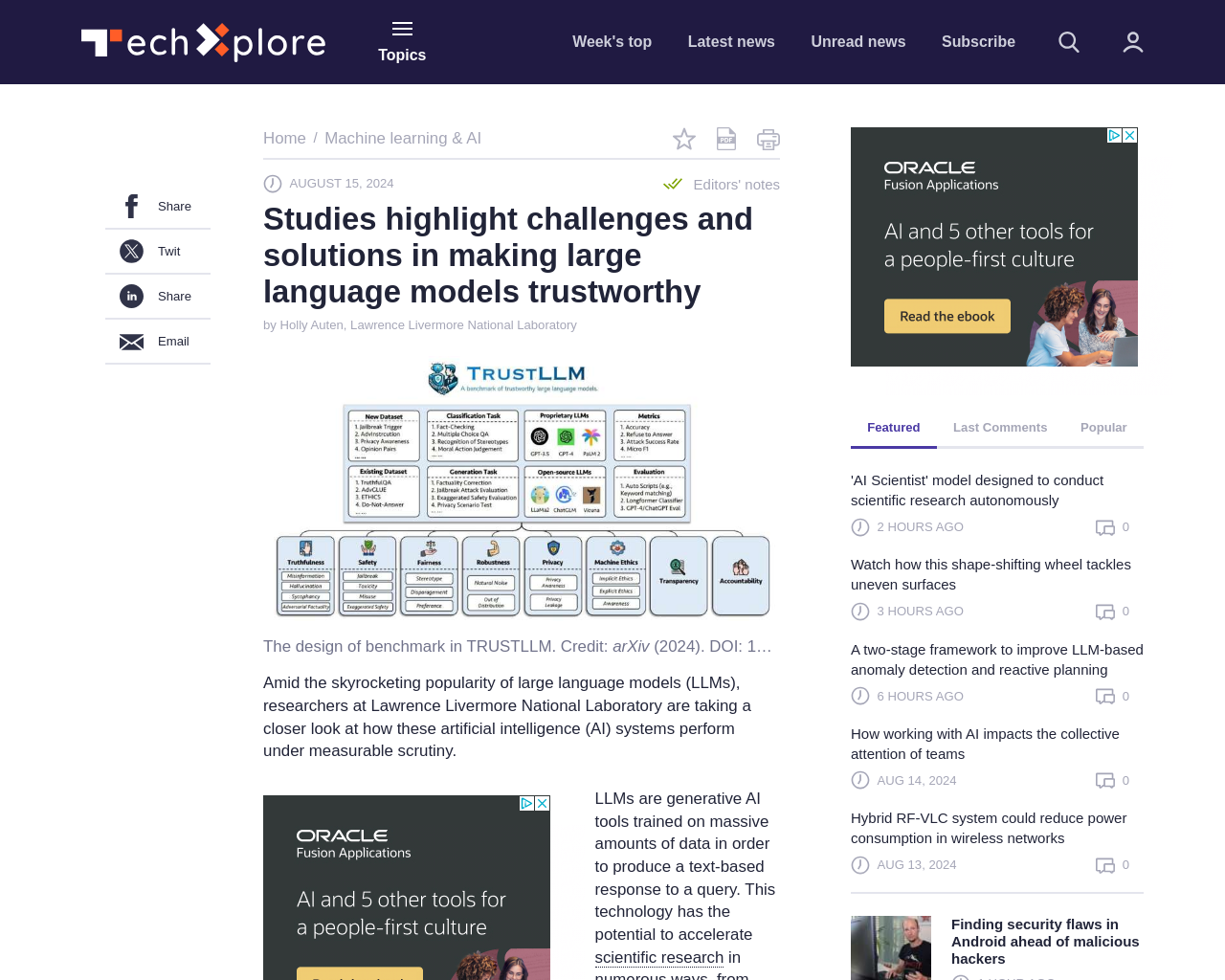

- TrustLLMフレームワークでは、LLMの信頼性を8つの次元で評価し、16の主要なLLMを検証した結果、全てのモデルが完全に信頼できるわけではないことが明らかになった。

- 圧縮による効率的なLLMの信頼性についての研究も行われ、一部の圧縮アルゴリズムがモデルのパフォーマンスを向上させることが示された。

感想:

LLMの信頼性に焦点を当てた研究は重要であり、大規模なデータセットや圧縮技術を活用しつつ、モデルの信頼性向上に取り組むことが必要であると感じます。TrustLLMフレームワークの提案や圧縮技術の検証により、信頼性の向上に向けた道筋が示されており、今後の研究や開発に期待が持てると思います。

元記事: https://techxplore.com/news/2024-08-highlight-solutions-large-language-trustworthy.html