要約:

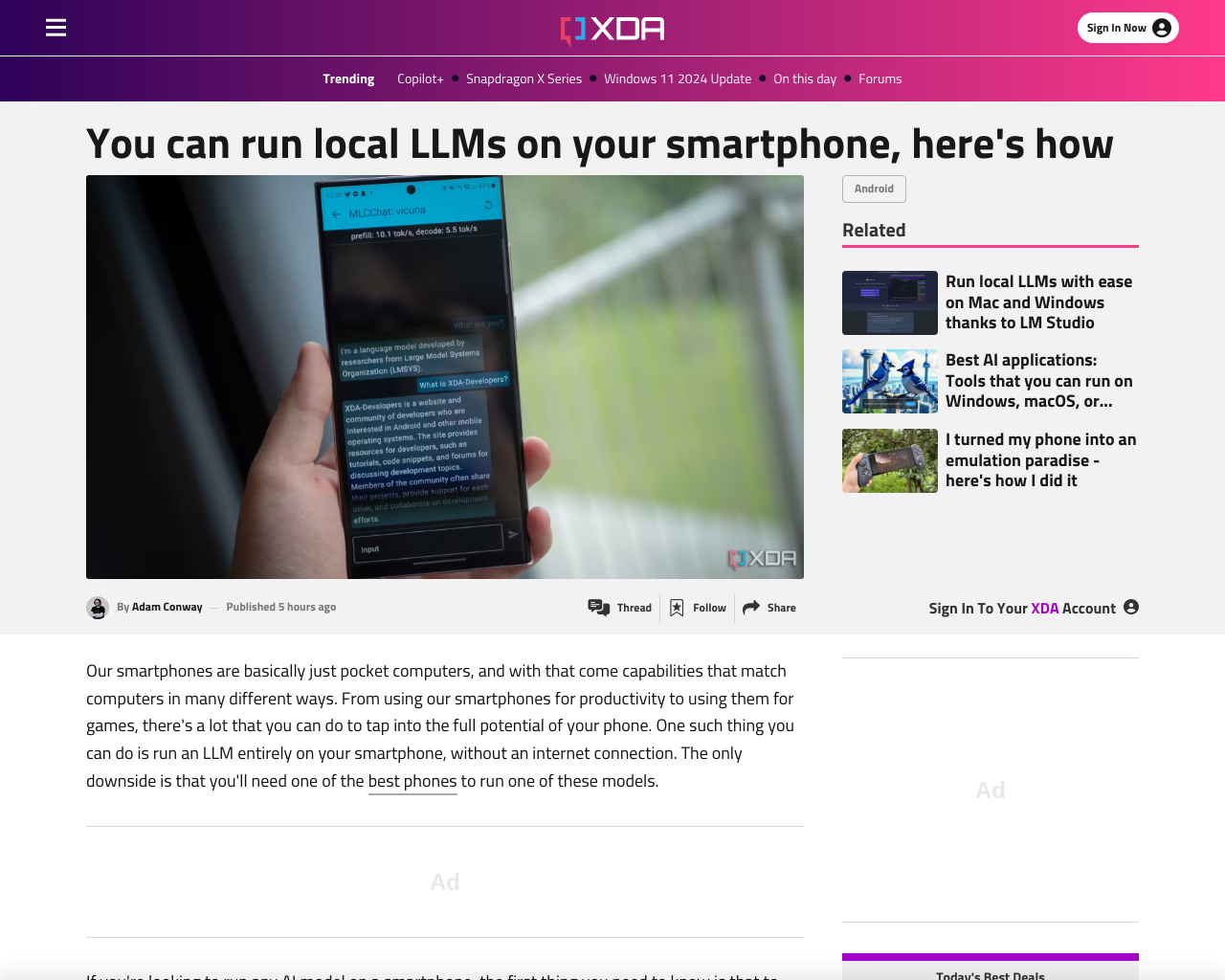

- スマートフォンはポケットコンピュータであり、LLMをインターネット接続なしで実行可能。

- スマートフォンでAIモデルを実行する場合、RAMが必要であり、大きな言語モデルをRAMにロードすることが重要。

- Vicuna-7Bは人気のモデルであり、Androidスマートフォンで6GBのRAMを使用。

- MLC LLMを使用することで、簡単にLLMをスマートフォンにインストールおよび実行可能。

感想:

スマートフォンでのLLMの実行は、技術の進歩により容易になっています。MLC LLMなどのツールを使用することで、高性能なモデルをスマートフォンで利用できるのは興味深いです。RAMの重要性やモデルのサイズに配慮しながら、スマートフォンでのAI活用は今後さらに広がる可能性があると感じます。

元記事: https://www.xda-developers.com/run-local-llms-smartphone/