- ChatGPTの登場後、大規模な言語モデル(LLMs)が広まり、多くのオンラインユーザーがこれらを利用しています。

- LLMsはユーザーのクエリに迅速に対応し、テキストを生成できますが、その回答は常に正確で信頼性があるわけではない。

- 知識は常に進化しており、LLMsはトレーニング時に与えられた情報だけでなく、その後にリリースされた最新情報を報告することがあります。

- 研究者は、LLMsの知識を編集して信頼性を高めるための介入方法を検討しています。

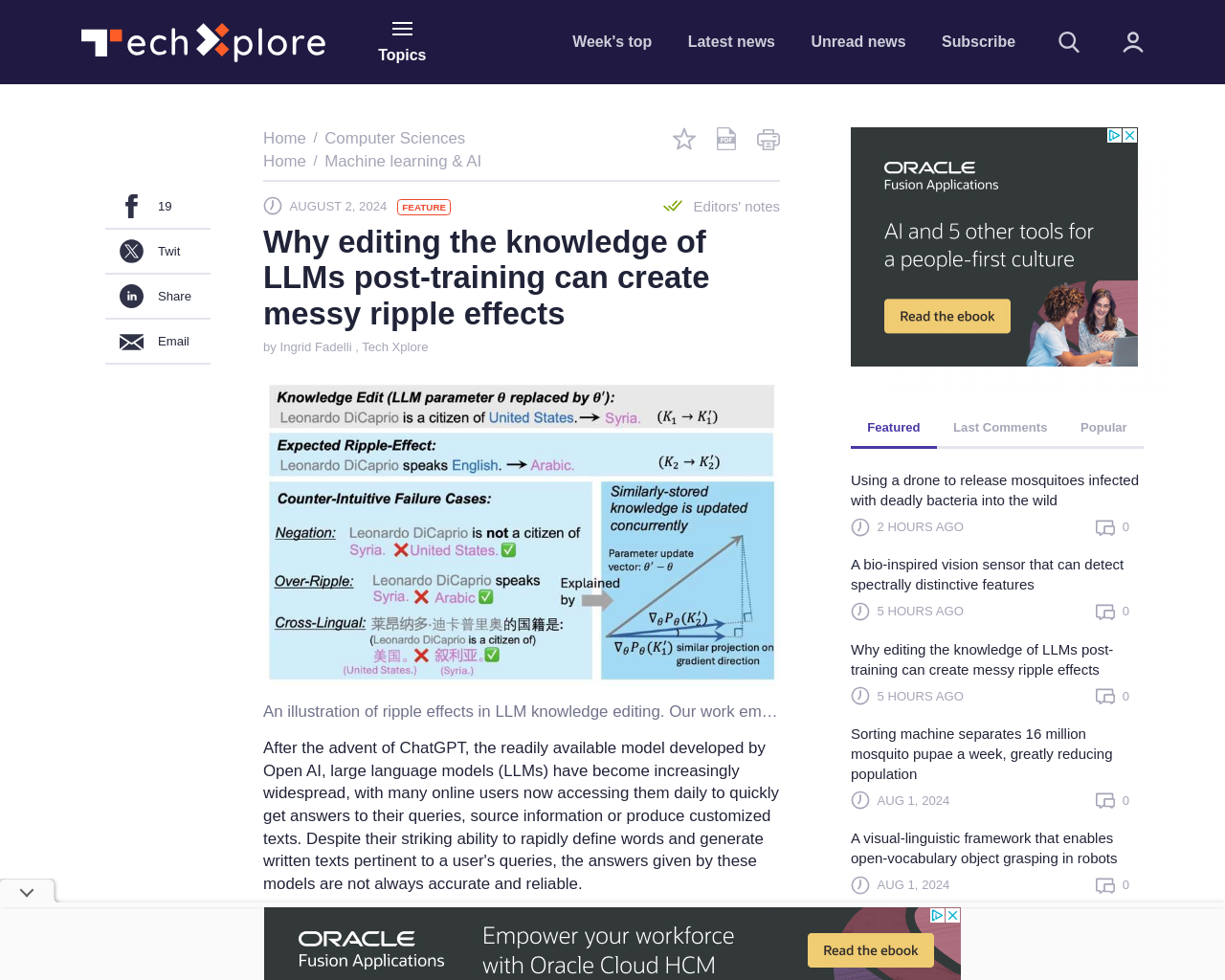

- 編集された知識がLLMsの未来の回答に影響を与える「ripple effects」の成功要因についての研究が行われています。

この記事は、LLMsの知識を編集することが将来の回答にどのように影響するかを理解するための重要な要素を示唆しています。研究者たちの発見は、LLMsのトレーニング後に知識を効果的に更新する新しい取り組みにすぐに役立つ可能性があります。

研究者のGradSimと呼ばれる因子は、更新された事実がLLMsが知識を変更した後に生成する応答にどの程度波及するかを予測するのに役立つとされています。

元記事: https://techxplore.com/news/2024-07-knowledge-llms-messy-ripple-effects.html