Technical Article Summary in Japanese:

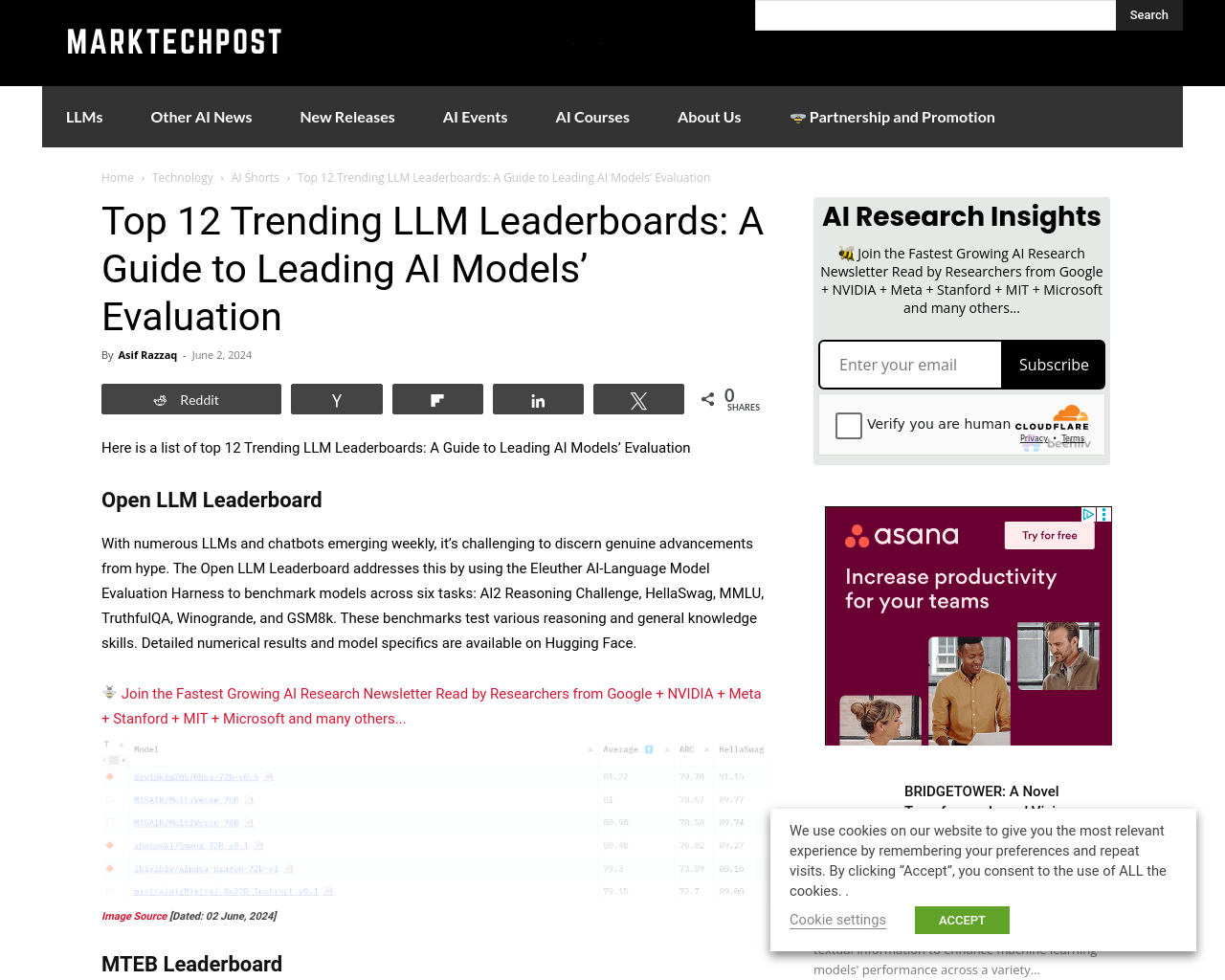

- Open LLM Leaderboardは、Eleuther AI-Language Model Evaluation Harnessを使用して、AI2 Reasoning Challenge、HellaSwag、MMLU、TruthfulQA、Winogrande、GSM8kなど6つのタスクでモデルをベンチマークしている。

- Massive Text Embedding Benchmark (MTEB)は、58のデータセットと112の言語を対象に、8つの埋め込みタスクで33のモデルを評価し、テキスト埋め込みの包括的な評価を提供している。

- HumanEvalとMultiPL-Eのベンチマークに基づいて、多言語コード生成モデルを比較し、関数の正確性、スループットなどを評価している。

- SEAL LeaderboardsはElo-scaleランキングを使用して、モデルのパフォーマンスを複数のデータセットで比較し、信頼性のあるモデル評価を実施している。

- Berkeley Function-Calling Leaderboard (BFCL)は、関数の呼び出し能力を評価し、GPT-4、OpenFunctions-v2、Mistral-mediumなどのモデルが現在のリーダーとして挙げられている。

Thoughts in Japanese:

これらのリーダーボードは、AIモデルの評価と比較を行う上で非常に重要であり、多くのタスクや言語においてモデルのパフォーマンスを包括的に評価しています。特に、テキスト埋め込みや関数呼び出し能力など、実用的な能力を測定することで、AIモデルの進化を追跡し、今後の改善に向けた方向性を示しています。これらの評価は、AI技術の進歩に寄与するだけでなく、ユーザーエクスペリエンスの向上にも繋がると考えられます。